مایکروسافت: کره شمالی و جمهوری اسلامی از هوش مصنوعی برای هک استفاده می کنند

غول فناوری ایالات متحده میگوید تهدیدات کشورهای خارجی را شناسایی کرده که از هوش مصنوعی مولد خود استفاده یا تلاش کردهاند از آن بهره برداری کنند

مایکروسافت: کره شمالی و جمهوری اسلامی از هوش مصنوعی برای هک استفاده می کنند

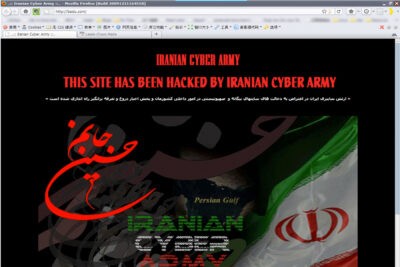

مایکروسافت روز چهارشنبه گفت، دشمنان ایالات متحده عمدتاً جمهوری اسلامی و کره شمالی، و تا حدی روسیه و چین شروع به استفاده از هوش مصنوعی مولد برای نصب یا سازماندهی عملیات سایبری تهاجمی کردهاند.

مایکروسافت اعلام کرد که با همکاری شریک تجاری OpenAI، بسیاری از تهدیدهایی را که با فناوری هوش مصنوعی برای سوء استفاده از آنها توسعه داده شده، شناسایی و مختل کرده است.

در یک پست وبلاگی، این شرکت گفت که این تکنیکها که در مراحل اولیه هستند بدیع یا منحصربهفرد نیستند، اما مهم است که آنها را بهعنوان رقبای آمریکایی که از مدلهای زبان بزرگ برای گسترش تواناییشان برای نفوذ به شبکهها و عملیات اعمال نفوذ استفاده میکنند، در معرض عموم قرار دهیم.

شرکتهای امنیت سایبری مدتهاست که از یادگیری ماشینی در دفاع، عمدتاً برای شناسایی رفتارهای غیرعادی در شبکهها استفاده میکنند. اما مجرمان و هکرهای تهاجمی نیز از آن استفاده میکنند، و معرفی مدلهای زبان بزرگ به رهبری ChatGPT OpenAI، این بازی موش و گربه را ارتقا داد.

مایکروسافت میلیاردها دلار در OpenAI سرمایهگذاری کرده است و اعلامیه روز چهارشنبه مصادف با انتشار گزارشی بود که در آن اشاره میشد که انتظار میرود هوش مصنوعی مولد مهندسی اجتماعی مخرب را تقویت کند و منجر به دیپفیکهای پیچیدهتر و شبیهسازی صدا شود. تهدیدی برای دموکراسی در سالی که در آن بیش از ۵۰ کشور انتخابات برگزار میکنند، اطلاعات نادرست را بزرگنمایی میکنند و در حال حاضر رخ داده است.

مایکروسافت چند نمونه ارائه کرد. در هر مورد، تمام حسابهای هوش مصنوعی و داراییهای گروههای نامبرده غیرفعال شدند.

گروه جاسوسی سایبری کره شمالی معروف به کیمسوکی از این مدلها برای تحقیق در اندیشکدههای خارجی که کشور را بررسی میکنند و تولید محتوایی که احتمالاً در کمپینهای هک فیشینگ نیزه استفاده میشود، استفاده کرده است.

سپاه پاسداران از مدلهای زبان بزرگ برای کمک به مهندسی اجتماعی، عیبیابی خطاهای نرمافزاری و حتی مطالعه چگونگی فرار نفوذگران از شناسایی در یک شبکه در معرض خطر استفاده کرده است. این شامل ایجاد ایمیلهای فیشینگ میشود که از جمله یکی که وانمود میکند از یک آژانس توسعه بینالمللی آمده است و دیگری تلاش برای فریب دادن فمینیستهای برجسته به وبسایتی که توسط مهاجمان درباره فمینیسم ساخته شده است. هوش مصنوعی به تسریع و افزایش تولید ایمیل کمک می کند.

واحد اطلاعات نظامی روسیه به نام Fancy Bear از این مدل ها برای تحقیق در مورد فناوری های ماهواره ای و راداری که ممکن است مربوط به جنگ در اوکراین باشد، استفاده کرده است.

گروه جاسوسی سایبری چینی معروف به پانداهای آبی که طیف وسیعی از صنایع، آموزش عالی و دولتها از فرانسه تا مالزی را هدف قرار میدهد با مدلها به شیوههایی تعامل کرده است که نشان میدهد کاوش محدودی در مورد اینکه چگونه LLMها میتوانند عملیات فنی خود را تقویت کنند.

گروه چینی Maverick Panda که بیش از یک دهه است پیمانکاران دفاعی ایالات متحده را در میان سایر بخشها هدف قرار داده است، تعاملاتی با مدلهای زبان بزرگ داشت که نشان میدهد کارآیی آنها را به عنوان منبع اطلاعات در مورد موضوعات بالقوه حساس، افراد با سابقه و منطقهای ارزیابی میکند.

در وبلاگ جداگانهای که روز چهارشنبه منتشر شد، OpenAI گفت ربات چت مدل GPT-4 فعلی آن تنها قابلیتهای محدود و افزایشی برای وظایف مخرب امنیت سایبری فراتر از آنچه در حال حاضر با ابزارهای در دسترس عمومی و غیر هوش مصنوعی قابل دستیابی است ارائه میکند.

محققان امنیت سایبری انتظار دارند که این تغییر کند. در آوریل گذشته، جن ایسترلی، مدیر آژانس امنیت سایبری و امنیت زیرساخت ایالات متحده، به کنگره گفت دو تهدید و چالش وجود دارد که این زمان را تعریف میکند. یکی چین است و دیگری هوش مصنوعی. ایسترلی در آن زمان گفت که ایالات متحده باید اطمینان حاصل کند که هوش مصنوعی با در نظر گرفتن امنیت ساخته شده است.

منتقدان انتشار عمومی ChatGPT در نوامبر ۲۰۲۲ و انتشارات بعدی توسط رقبا از جمله گوگل و متا ادعا می کنند که به طور غیرمسئولانه ای عجولانه بود، زیرا امنیت تا حد زیادی در توسعه آن ها فکر می کرد.

آمیت یوران، مدیر اجرایی شرکت امنیت سایبری تنبل، گفت البته بازیگران بد از مدلهای زبان بزرگ استفاده میکنند این تصمیم زمانی گرفته شد که جعبه پاندورا باز شد.

برخی از متخصصان امنیت سایبری از ایجاد و استفاده از ابزارهای مایکروسافت برای رفع آسیبپذیریها در مدلهای بزرگ زبان شکایت دارند، در حالی که ممکن است مسئولانهتر بر روی ایمنتر کردن آنها تمرکز کند.

گری مک گرو، کهنه کار امنیت رایانه و یکی از بنیانگذاران مؤسسه یادگیری ماشینی بریویل، پرسید چرا به جای فروش ابزارهای دفاعی برای مشکلی که به ایجاد آن کمک می کنند، مدل های پایه جعبه سیاه LLM ایمن تر ایجاد نکنید؟

ادوارد آموروسو، استاد دانشگاه نیویورک و افسر ارشد سابق AT&T، گفت که اگرچه استفاده از هوش مصنوعی و مدلهای زبان بزرگ ممکن است یک تهدید فوری آشکار نباشد، اما در نهایت به یکی از قویترین سلاحها در تهاجم نظامی هر کشور دولتی تبدیل خواهند شد.